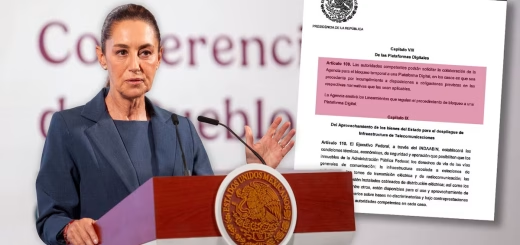

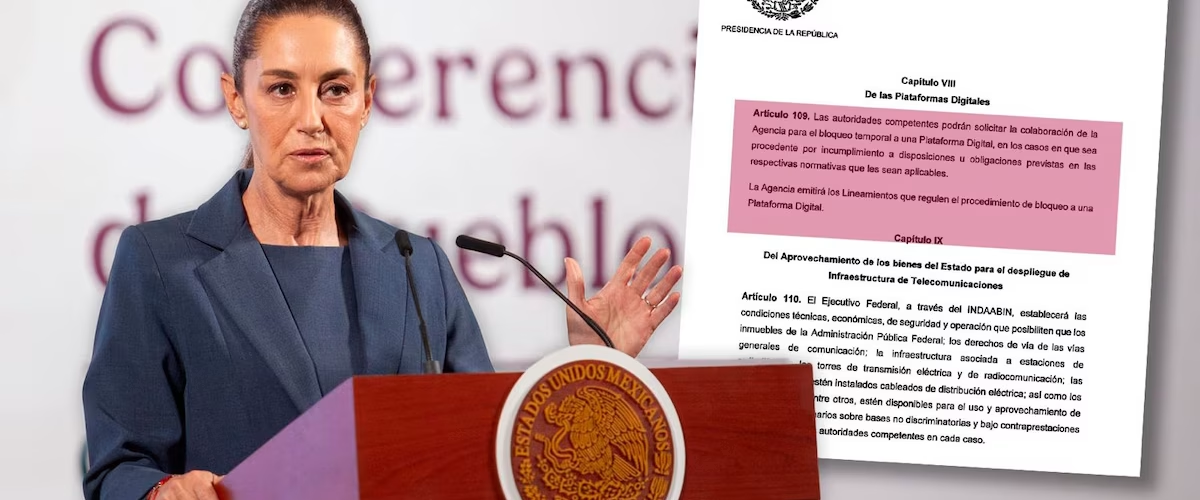

Art.109: ¿qué moderar?, ¿cómo hacerlo?

Manuel Alejandro Guerrero

La iniciativa que ha presentado esta semana el gobierno federal para reformar la Ley Federal de Telecomunicaciones y Radiodifusión ha generado una enorme controversia.

A pesar de que contiene aspectos positivos como mecanismos compensatorios a operadores que expandan la cobertura social y la interconectividad en términos no discriminatorios, así como también reafirma los derechos de las audiencias y la neutralidad de la red, tiene otros aspectos que requieren mayor reflexión pues su actual redacción pone en riesgo derechos y libertades fundamentales.

Quizá uno de estos aspectos se encuentra en el art. 109 de la iniciativa que dice: “Las autoridades competentes podrán solicitar la colaboración de la Agencia [de Transformación Digital y Telecomunicaciones, una dependencia directa del gobierno federal] para el bloqueo temporal de una plataforma digital, en los casos en que sea procedente por incumplimiento a disposiciones u obligaciones previstas en las respectivas normativas que le sean aplicables. La Agencia emitirá los lineamientos que regulen el procedimiento de bloqueo de una plataforma digital”.

Ante los cuestionamientos sobre este artículo, la Presidenta Sheinbaum, en su conferencia del jueves 24 de abril, señaló que su gobierno no pretende la censura y que, “en todo caso, [habría que] corregir la redacción”. En efecto, hay, al menos, tres aspectos problemáticos con la forma en que está redactada esta disposición para la libertad de expresión: a) la posibilidad del bloqueo no requiere de una orden judicial que previamente haya establecido la supuesta ilegalidad ni el grado de gravedad que la justifique; b) no hay parámetros que definan la temporalidad (auque estos puedan resultar de los lineamientos); c) se pasa por alto que las restricciones legítimas a la libertad de expresión deben estar establecidas en ley, ser congruentes con estándares internacionales, y tener claro su carácter excepcional y su proporcionalidad. ¿Qué nos dice la experiencia internacional sobre los contenidos? ¿Qué contenidos deben moderarse? ¿Quién es responsable? ¿Cómo hacerlo?

Para empezar es importante establecer qué tipo de contenido está bajo la mira. Por ejemplo, la Ley de Servicios Digitales de la Unión Europea, la iniciativa de ley de Inteligencia Artificial de Brasil, y los Códigos de Contenido Ilegal del Reino Unido distinguen entre contenidos ilegales (aquellos que suponen una violación a la ley, como material de abuso infantil, contenido relacionado con terrorismo o incitación a la violencia) y contenidos dañinos (aquellos que pueden no ser ilegales pero que aún pueden causar un daño psicológico significativo o daño social, como desinformación, ciberacoso o discurso de odio). Mientras que las regulaciones obligan a las plataformas a una rápida remoción de los primeros, el contenido dañino requiere revisiones contextualizadas y matizadas con el fin de equilibrar la libertad de expresión con la protección de los usuarios. En Estados Unidos, aunque no hay una ley única, sí existen regulaciones específicas sobre contenidos ilegales en áreas como el terrorismo o la pornografía infantil. En China, en cambio, el contenido considerado dañino, como desinformación y discurso de odio, también se marca y elimina mediante una combinación de sistemas automatizados y revisión humana.

En la mayoría de los lugares, los operadores de plataformas (las empresas tecnológicas detrás de sitios web y aplicaciones) asumen la mayor parte de la responsabilidad en la moderación de contenido y los gobiernos supervisan su cumplimiento. Es el caso del Reino Unido, a través de su Oficina de Comunicaciones (Ofcom), de la Unión Europea, a través de una coresponsabilidad entre la Comisión Europea y las agencias nacionales en cada país. En el caso de la iniciativa brasileña, las plataformas deben asegurarse de cumplir con normas éticas y legales y, si éstas no actúan lo suficientemente rápido para eliminar contenido ilegal, pueden ser multadas o penalizadas. En Reino Unido, en Europa y para el caso de Brasil, se exige a las plataformas presentar reportes bimestrales o trimestrales de transparencia en los que también deban especificar, al menos, qué contenidios se suspendieron, las razones y criterios, y la temporalidad.

En Estados Unidos, el ambiente ha ido cambiado rápidamente: si como resultado de la oleada de desinformación y contenidos engañosos que comenzó en 2016 con la primera campaña de Trump, las plataformas establecieron códigos de ética, mayor vigilancia a contenidos tóxicos y mecanismos internos y externos (alianzas con agencias verificadoras) de supervisión, en el último año el péndulo ha oscilado al otro extremo. Las grandes plataformas han ido cancelando este tipo de acciones y retirando fondos y apoyos a verificadores y otros organismos que ayudaban a supervisar la toxicidad de cierto tipo de contenidos. Más aún, el presidente Trump firmó una orden ejecutiva el 20 de enero para “restaurar la libertad de expresión y terminar la censura” en la que echaba para atrás todas las acciones de la administración Biden, donde las plataformas, voluntariamente, asumían la responsabilidad de promover un ambiente digital más seguro y menos tóxico. El resultado: más contenidos de todo tipo y calidad, para bien y para mal.

En China, las reglas para la moderación de contenido son bastante únicas. El gobierno tiene un papel mucho más directo en el proceso. Las plataformas, como Douyin (el homólogo chino de TikTok), son responsables de moderar el contenido, pero bajo una estricta supervisión estatal. Las plataformas deben seguir prácticas de gestión del “ecosistema de contenido”, lo que significa que también deben monitorear cómo las interacciones de los usuarios (como comentarios y respuestas compartidas) afectan el impacto general del contenido. Las penalizaciones por no cumplir incluyen multas y restricciones operativas.

En suma, la gama de experiencias sobre la definición de qué tipos de contenido deben ser supervisados y cómo debe hacerse deja claro que hay variedad. En los extremos, tenemos los casos de Estados Unidos, donde hoy circula casi cualquier tipo de contenido, y de China, donde incluso los contenidos dañinos son retirados. Tenemos también que, en los casos de la Unión Europea, el Reino Unido, y Brasil, la moderación recae principalmente en manos de las plataformas, pero los gobiernos –mediante reglas y procedimientos claros—supervisan su cumplimiento. Lo anterior implica también marcos legales que definen parámentros sobre los contenidos y, sobre todo, sobre la actuación de las autoridades supervisoras frente a la resposabilidad irrenuciable de las propias plataformas. En el caso de la Unión Europea, Reino Unido y Brasil, destacan dos conceptos al respecto: rendición de cuentas y transparencia. Y esto es justamente lo que necesitaríamos añadir en la discusión en México sobre el complejo asunto de los alcances y los límites de la autoridad frente a la libertad de expresión en un caso, como el Art.109.

Con información de El Sol de México